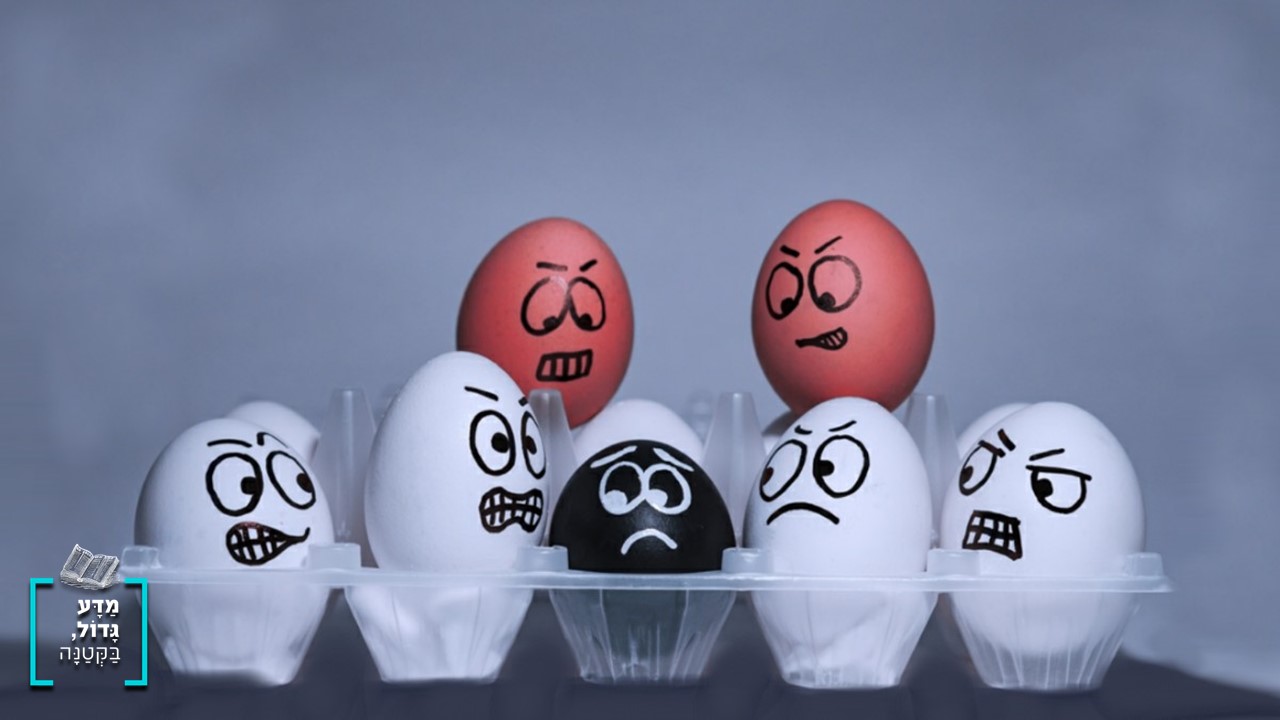

מחקר חדש שהתפרסם בכתב-העת Science מוצא שאלגוריתם שבו נעשה שימוש בבתי חולים רבים בארה"ב היה מוטה לטובת חולים לבנים, ובעיקר הפלה לרעה שחורים. נסביר כיצד אלגוריתם עשוי ללמוד להיות גזעני.

פרסומת

בעשרות השנים האחרונות חלו התפתחויות ענק בתחום המחשוב בכלל ובתחום הבינה המלאכותית בפרט. הסמארטפון שכל אחד מאיתנו מחזיק בכיס הוא בעל כח חישוב הרבה יותר גדול משל המחשב שבו נעשה שימוש בהנחתה של אפולו 11 על הירח. כח חישוב גדול מאפשר לנו להריץ אלגוריתמים של למידת מכונה על מאגרי מידע ענקיים, ולקבל כלים שעוזרים לנו לבצע פעולות שבעבר היו קשות.

דוגמה לכלי כזה היא תוכנה מסחרית המאפשרת למיין חולים במהירות בבתי חולים בארה"ב. היות וזה מחשב אז הסיווג אמור גם להיות בלתי מוטה ואחיד. לפני כשבוע התפרסם בירחון Science מאמר [1] שמראה שההנחה האחרונה לא מדויקת. התוכנה מפלה חולים שחורים: חולים לבנים וחולים שחורים עם תסמינים דומים ומחלות דומות סווגו ברמת סיכון שונה. רמת הסיכון אצל הלבנים היתה גבוהה יותר ולכן קיבלו טיפול מהיר ויעיל יותר.

עיקר התרומה של המאמר הוא במציאת ההטיה ואת הסיבה לאותה הטיה. היות והאלגוריתם בו נעשה שימוש הוא מסווג מסחרית, לחוקרים לא היתה גישה למשוואות שלו, לכן לא יכלו לדעת כיצד הוא פועל. לחוקרים כן הייתה יכולת לבדוק את הנתונים שהוזנו לאלגוריתם, ויכלו לאמת תחזיות שהאלגוריתם נתן לפני שנה, עם מצב החולים היום. כדי לבדוק האם אלגוריתם כלשהו הוא מוטה או לא, משתמשים המהנדסים במגוון רחב של כלים מתמטיים. כלים אלו מיושמים כדי לבדוק את הכיול של התוצאות לנתונים. החוקרים מצאו שהאלגוריתם היה מכוייל היטב כשבודקים צפי לעלות הטיפול בחולה, אבל סבל מהטיה בשיערוך סיכון רפואי של חולים מרקעים אתניים שונים. הטיה הגדולה ביותר הייתה לרעת שחורים. כלים סטטיסטיים דומים הופעלו על נתונים שונים כדי לחפש את הסיבה להטיה. לדוגמא, מה הסיכוי שאדם שנכנס למיון יתויג בטעות כבעל סיכון נמוך אם יש לו מחלה כרונית, ומה הסיכוי שיתויג בטעות כבעל סיכון נמוך אם הוציא הרבה או מעט כסף על בריאות.

הסיבה לאפליה היתה שאחד המאפיינים בהם התוכנה עשתה שימוש, היה ההוצאה הכספית שהוציא המטופל על בריאות. הסברה שעמדה בבסיס הייתה שככל שהמטופל הוציא יותר כסף כך הוא יהיה חולה יותר. הגיוני, לא? רק שלאנשים עניים בארה"ב יש פחות כסף להוציא על טיפולים ולכן, סווגו ברמה נמוכה יותר של סיכון. מסיבות היסטוריות וסוציולוגיות שונות ההטיה הזו גרמה לכך שהסיכוי של חולה שחור לקבל טיפול הולם היה קטן משמעותית משל חולה לבן. כך יצא שתוכנה שמשתמשים בה במספר רב של בתי חולים נתנה תוצאה מפלה.

הפעם, תוצאות האלגוריתם היו מפלות בגלל מאפיין אחד ספציפי מהנתונים. אבל זו לא הפעם הראשונה שאלגוריתמים, בעיקר אלגוריתמים שמשתמשים בלמידה, נותנים תוצאה מוטה. לפני כשנה התפרסם שתוכנה של אמאזון שאמורה למיין קורות חיים, מפלה נשים לרעה [2]. באותו מקרה, זה לא קרה בשל מאפיין בעייתי, אלא משום שרוב קורות החיים שהוגשו במשך 10 שנים היו של גברים, והתכנה למדה לסנן החוצה את הנשים (זה הגיע למצב שהאלגוריתם הוריד נקודות לקו"ח רק כי היה של אישה).

תוכנות של זיהוי פנים סובלות הרבה מהטיות שנגרמות בגלל סט נתונים מוטה כמו במקרה של תכנות לזיהוי הפנים של אמאזון, שטעתה יותר בסיווג בין נשים שונות ואנשים שונים (כל עוד הם לא לבנים): המערכת אומנה על סט תמונות שהכיל בעיקר גברים לבנים, ולכן השגיאה הגדולה ביותר הייתה בסיווג נשים שחורות [3]. הטיות באלגוריתמים גם נמצאו בכלי עזר משטרתי ושיפוטי להערכת סיכון של חשודים, שסיווג שחורים כמסוכנים יותר [4], וגם בכלי שיועד להערכת סיכון של אסירים שמועמדים לשחרור מוקדם [5]. עוד לא הוכחה הסיבה להטיה באלגוריתמים תומכי ההחלטות השיפוטיות, אבל יש שסוברים שהאלגוריתמים האלה מסתמכים על החלטות מהעבר ושהם פשוט למדו את ההטיה ישירות מבני האדם.

עקב ריבוי המקרים האלה, בשנים האחרונות הולך וגדל תחום מחקר שלם של הוגנות בבינה מלאכותית (AI Fairness). החוקרים בתחום מתמקדים בעיקר בשתי חזיתות: חשיפת אלגוריתמים לא הוגנים ונסיונות לשפר אותם (כמו המאמר האחרון ב - [1] Science), ופיתוח אלגוריתמים הוגנים כך שהלמידה שלהם תהיה כזו שתביא לתוצאות הוגנות למרות הטיות בנתונים.

מקורות:

[2] תכנת מיון קורות חיים של אמאזון

[3] קושי בתיוג פנים